Nächste Seite: 13 Euklid'ische Geometrie Aufwärts: Mathematik 1 für Informatik Vorherige Seite: 11 Gleichungssysteme Inhalt Index

Wir wollen nun eine Methode behandeln, welche uns erlaubt die Invertierbarkeit einer linearen Abbildung festzustellen und auch Formeln für die Inverse liefert.

12.1 Bemerkung.

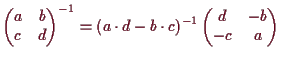

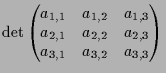

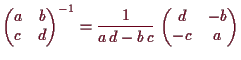

Wir haben in (10.27) gezeigt, daß eine Matrix

genau dann invertierbar ist, wenn

genau dann invertierbar ist, wenn

![]() es ist

und die Inverse ist dann durch

es ist

und die Inverse ist dann durch

Der Ausdruck

![]() heißt Determinante von

heißt Determinante von

![]() und wird mit

und wird mit

![]() bezeichnet. Die geometrische Bedeutung von

bezeichnet. Die geometrische Bedeutung von

![]() ist gerade

gelbe Fläche des Parallelogramms

ist gerade

gelbe Fläche des Parallelogramms

![]() in folgender Zeichnung,

in folgender Zeichnung,

![\includegraphics[scale=0.7]{linalg-1001}](img3156.png)

den diese

ergibt sich aus der Fläche

![]() des Rechtecks

des Rechtecks

![]() vermindert um die blaue Fläche

vermindert um die blaue Fläche

![]() der beiden Rechtecke

der beiden Rechtecke

![]() und

und

![]() sowie

die gemeinsame Fläche

sowie

die gemeinsame Fläche

![]() der beiden roten Dreiecke

der beiden roten Dreiecke

![]() und

und

![]() und die gemeinsame Fläche

und die gemeinsame Fläche

![]() der beiden grünen Dreiecke

der beiden grünen Dreiecke

![]() und

und

![]() .

Insgesamt also

.

Insgesamt also

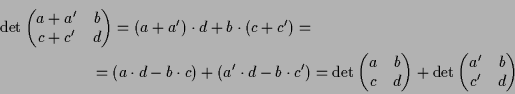

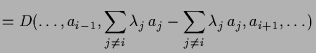

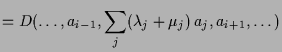

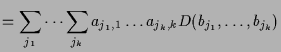

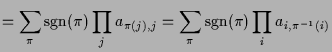

Die Determinante von

![]() -Matrizen ist bilinear, denn

-Matrizen ist bilinear, denn

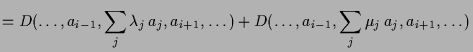

Geometrisch liegt das daran, daß wir im Parallelogrammen eine Seite unter Beibehaltung der Höhe verschieben dürfen. Wir können also o.B.d.A. annehmen, daß zwei Rechtecke vorliegen. Für diese ist diese Additionseigenschaft aber offensichtlich:

![\includegraphics[scale=0.7]{pic-1049}](img3172.png)

Wir versuchen dies nun auf höher-dimensionale

![]() übertragen.

Erstes Ziel dabei ist eine Funktion

übertragen.

Erstes Ziel dabei ist eine Funktion

![]() anzugeben

die

anzugeben

die

![]() Vektoren

Vektoren

![]() das Volumen

das Volumen

![]() des von Ihnen aufgespannten

Parallelipipeds zuordnet.

Solch eine Funktion müßte offensichtlich folgende Eigenschaften haben:

des von Ihnen aufgespannten

Parallelipipeds zuordnet.

Solch eine Funktion müßte offensichtlich folgende Eigenschaften haben:

Jede Determinantenfunktion hat folgende weitere Eigenschaften:

| (1) | ||

| (2) |

|

||

|

||

|

||

|

||

12.2 Bemerkung.

Determinantenfunktionen sind im wesentlichen eindeutig, d.h. durch

ihren Wert auf einer Basis eindeutig bestimmt.

Beweis. Es sei

|

||

|

||

|

||

|

Bemerkung.

Es sei

![]() eine Determinatenfunktion und

eine Determinatenfunktion und

![]() eine Basis.

Wegen

eine Basis.

Wegen

![]() existieren Vektoren

existieren Vektoren

![]() mit

mit

![]() und wegen der Formel im Beweis von (12.2)

ist somit auch

und wegen der Formel im Beweis von (12.2)

ist somit auch

![]() .

.

Mittels Determinantenfunktion können wir lineare Unabhängigkeit erkennen:

12.3 Lemma.

Es sei

![]() eine Determinatenfunktion und

eine Determinatenfunktion und

![]() .

Dann ist

.

Dann ist

![]() genau dann linear abhängig, wenn

genau dann linear abhängig, wenn

![]() .

.

Beweis. (

(

![]() ) Angenommen

) Angenommen

![]() ist linear unabhängig,

so ist

ist linear unabhängig,

so ist

![]() ,

denn

,

denn

![]() .

[]

.

[]

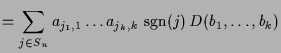

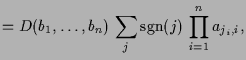

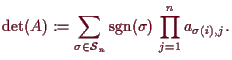

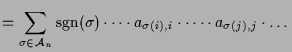

12.5 Definition.

Für eine Matrix

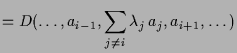

![]() definieren wir die Determinante durch die Leibniz-Formel als

definieren wir die Determinante durch die Leibniz-Formel als

12.4 Proposition.

Die Funktion

![]() ist eine Determinantenfunktion.

ist eine Determinantenfunktion.

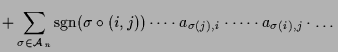

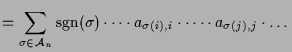

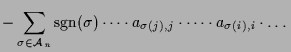

Beweis. Es ist

|

||

|

||

|

||

|

||

|

|

||

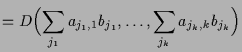

![\bgroup\color{demo}$\displaystyle \xymatrix{

a_{1,1}\ar@{-{}}[1,1] &a_{1,2}\ar@{...

...&a_{3,2}\ar@{-{}}[-1,1] &a_{3,3}\ar@{-{}}[-1,1] &

a_{3,1} &a_{3,2} \\

}$\egroup](img3259.png)

12.7 Beispiel.

Die Determinante einer Diagonalmatrix (d.h.

![]() für alle

für alle

![]() ) ist gerade das Produkt

der Diagonalelemente, den nur für

) ist gerade das Produkt

der Diagonalelemente, den nur für

![]() ist

ist

![]() .

.

Allgemeiner ist die Determinante einer Dreiecksmatrix ist gerade das Produkt

der Diagonalelemente, den nur für

![]() ist

ist

![]() .

In der Tat sei

.

In der Tat sei

![]() z.B. eine obere Dreiecksmatrix, d.h.

z.B. eine obere Dreiecksmatrix, d.h.

![]() für

alle

für

alle

![]() . Somit ist

. Somit ist

![]() falls

falls

![]() für

mindestens ein

für

mindestens ein

![]() ist. Nur die Permutationen

ist. Nur die Permutationen

![]() mit

mit

![]() für

alle

für

alle

![]() erfüllen

erfüllen

![]() . Die einzige Permutation mit

dieser Eigenschaft ist aber

. Die einzige Permutation mit

dieser Eigenschaft ist aber

![]() .

.

12.8 Multiplikationssatz.

Für

![]() gilt

gilt

![]() .

.

Beweis. Es sei

|

||

Bemerkung.

Nach der einleitenden Motivation (12.2) ist

![]() gerade das

gerade das

![]() -dimensionale

Volumen des von den Spalten

-dimensionale

Volumen des von den Spalten

![]() von

von

![]() erzeugten Parallelipipeds

erzeugten Parallelipipeds

![]() ,

also vom Bild unter

,

also vom Bild unter

![]() des Einheitsquaders (den von den Standardbasis

des Einheitsquaders (den von den Standardbasis

![]() erzeugten Parallelipipeds).

Der Multiplikationssatz besagt nun gerade, daß

das Volumen

erzeugten Parallelipipeds).

Der Multiplikationssatz besagt nun gerade, daß

das Volumen

![]() des Bildes unter

des Bildes unter

![]() des von

des von

![]() erzeugten

Parallelipipeds

erzeugten

Parallelipipeds

![]() gerade das Volumen

gerade das Volumen

![]() des Parallelipipeds

des Parallelipipeds

![]() multipliziert mit

multipliziert mit

![]() ist. Somit mißt

ist. Somit mißt

![]() gerade das Verhältnis

des Volumens des Bildes

gerade das Verhältnis

des Volumens des Bildes

![]() von Parallelipipeden

von Parallelipipeden

![]() unter

unter

![]() zu

dem Volumen von

zu

dem Volumen von

![]() . Dies stimmt nicht nur für Parallelipipede sondern

für beliebige Körper

. Dies stimmt nicht nur für Parallelipipede sondern

für beliebige Körper

![]() welchen man ein Volumen zuordnen kann.

welchen man ein Volumen zuordnen kann.

Wir können nun die Determinante benutzen um Invertierbarkeit zu erkennen:

12.10 Proposition.

Es ist

![]() genau dann invertierbar, wenn

genau dann invertierbar, wenn

![]() ist.

ist.

Beweis. Nach (10.21) ist

12.11 Lemma.

Für invertierbares

![]() gilt

gilt

![]() .

.

Beweis. Wegen dem Multiplikationssatz (12.8) ist die Determinante der inversen Matrix gerade der Kehrwert der Determinante, denn

12.9 Bemerkung.

Für ein

![]() ist

ist

![]() als

als

![]() für irgendeine Matrixdarstellung

für irgendeine Matrixdarstellung

![]() von

von

![]() definiert, d.h. als

definiert, d.h. als

![]() ,

wobei

,

wobei

![]() der durch eine

Basis

der durch eine

Basis

![]() gegebene Isomorphismus ist aus (10.16).

Ist

gegebene Isomorphismus ist aus (10.16).

Ist

![]() eine weitere Basis und

eine weitere Basis und

![]() der

entsprechende Isomorphismus, so ist mit

der

entsprechende Isomorphismus, so ist mit

![]()

12.12 Definition.

Die Transponierte einer Matrix

![]() ist die Matrix

ist die Matrix

![]() ,

die durch Spiegelung von

,

die durch Spiegelung von

![]() an der Diagonale entsteht.

an der Diagonale entsteht.

Offensichtlich ist

![]() ,

,

![]() sowie

sowie

![]() .

.

Beweis.

|

||

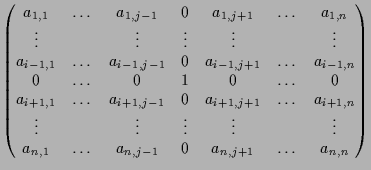

Unser nächstes Ziel ist nun eine Formel für die Inverse invertierbarer

Matrizen

![]() zu entwickeln.

zu entwickeln.

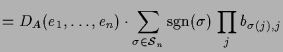

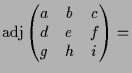

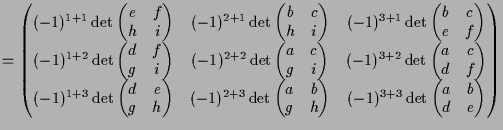

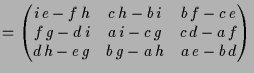

12.14 Definition.

Es sei

![]() eine quadratische Matrix.

Für

eine quadratische Matrix.

Für

![]() versteht man unter dem

versteht man unter dem

![]() -ten

algebraischen Komplement

-ten

algebraischen Komplement

![]() von

von

![]() die

Determinante

die

Determinante

![]() ,

also die Determinante folgender Matrix

,

also die Determinante folgender Matrix

|

Als Adjungierte

![]() einer Matrix

einer Matrix

![]() bezeichnet man nun jene Matrix die

an der

bezeichnet man nun jene Matrix die

an der

![]() -ten Zeile und

-ten Zeile und

![]() -ten Spalte das

-ten Spalte das

![]() -te algebraische Komplement

-te algebraische Komplement

![]() von

von

![]() hat (Beachte die Vertauschung der Indizes).

hat (Beachte die Vertauschung der Indizes).

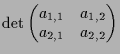

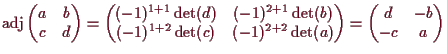

Beispiel.

Die Adjungierte einer

![]() -Matrix ist somit wie folgt gegeben

(vergleiche dies mit der Formel aus (10.27))

-Matrix ist somit wie folgt gegeben

(vergleiche dies mit der Formel aus (10.27))

|

||

|

||

|

12.15 Bemerkung.

Es seien

![]() die Eintragungen der Matrix

die Eintragungen der Matrix

![]() der Identität

der Identität

![]() , d.h.

, d.h.

![]() und

und

![]() für

für

![]() .

Man nennt dies das Kronecker-Delta.

Dann ist

.

Man nennt dies das Kronecker-Delta.

Dann ist

Damit erhalten wir die erhoffte Formel für die Inverse einer Matrix:

Vergleiche dies mit der Formel

Beweis. Die Gleichung

Division durch

![]() zeigt, daß

zeigt, daß

![]() eine

links-Inverses ist. Offensichtlich ist

eine

links-Inverses ist. Offensichtlich ist

![]() und somit folgt durch Transponieren von

und somit folgt durch Transponieren von

![]() die Identität

die Identität

![]() , also ist

, also ist

![]() die Inverse von

die Inverse von

![]() .

[]

.

[]

Allgemeiner als in (12.3) können wir mittels Determinanten auch die lineare Abhängigkeit beliebig vieler Vektoren feststellen:

12.19 Folgerung.

Vektoren

![]() sind genau dann linear abhängig, wenn

die Determinante jeder der

sind genau dann linear abhängig, wenn

die Determinante jeder der

![]() vielen

vielen

![]() -Teilmatrizen

der

-Teilmatrizen

der

![]() -Matrix

-Matrix

![]() gleich 0 ist.

gleich 0 ist.

Beweis. (

(

![]() ) Indirekt. Angenommen

) Indirekt. Angenommen

![]() ist linear unabhängig,

obwohl alle Determinanten der

ist linear unabhängig,

obwohl alle Determinanten der

![]() -Teilmatrizen von

-Teilmatrizen von

![]() gleich 0 sind. Nach (9.13) könne wir

gleich 0 sind. Nach (9.13) könne wir

![]() durch Hinzufügen von

Vektoren

durch Hinzufügen von

Vektoren

![]() zu einer Basis ergänzen. Nach (12.3) ist

damit

zu einer Basis ergänzen. Nach (12.3) ist

damit

![]() . Laplace-Entwicklung nach den Spalten zeigt

jedoch induktiv nach

. Laplace-Entwicklung nach den Spalten zeigt

jedoch induktiv nach

![]() , daß alle

, daß alle

![]() -Teilmatrizen von

-Teilmatrizen von

![]() verschwindende Determinante besitzen, ein Widerspruch.

[]

verschwindende Determinante besitzen, ein Widerspruch.

[]

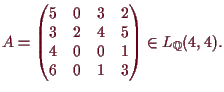

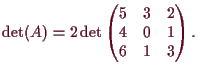

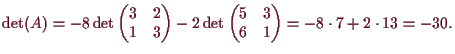

Beispiel.

(1) In manchen Fällen führt die Entwicklung nach einer Zeile oder

einer Spalte schnell zur Berechnung einer Determinante. Betrachten

wir etwa die Matrix

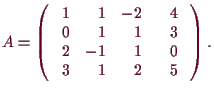

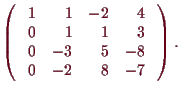

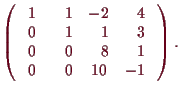

(2) In den meisten Fällen ist der beste Weg zur Berechnung einer Determinante die Anwendung von elementaren Zeilen- oder Spaltenoperationen. Betrachten wir als Beispiel die Matrix

Auch die Lösungen linearer Gleichungen können wir - sofern diese eindeutig sind - mittels Determinanten berechnen:

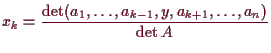

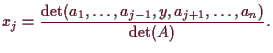

12.17 Cramer'sche Regel.

Falls

![]() invertierbar ist, so ist die Lösung von

invertierbar ist, so ist die Lösung von

![]() durch

durch

Beweis. Die Gleichung

Wenn

![]() invertierbar ist, dann ist

invertierbar ist, dann ist

![]() invertierbar

nach (6.22) und somit existiert eine eindeutige Lösung

invertierbar

nach (6.22) und somit existiert eine eindeutige Lösung

![]() von

von

![]() . Nach dem ersten Teil erfüllt diese

. Nach dem ersten Teil erfüllt diese

![]() , also folgt

, also folgt

12.18 Bemerkung.

Für die praktische Lösung von linearen Gleichungssystemen ist

die Cramer'sche Regel nicht besonders gut geeignet, weil die

Berechnung der vielen Determinanten zu aufwendig ist. Daher lösen

Computerprogramme lineare Gleichungssysteme nicht mit dieser

Methode. Um das zu sehen, bestimmen wir, wie viele

Rechenoperationen zur Lösung eines linearen Gleichungssystems mit

![]() Gleichungen in

Gleichungen in

![]() Unbekannten über einem Körper nötig

sind. Wir werden uns dabei auf die Multiplikationen und Divisionen

beschränken (die mehr Rechenaufwand benötigen) und Additionen,

Subtraktionen und Vertauschungen von Zeilen oder Spalten außer

Acht lassen.

Die Determinante einer

Unbekannten über einem Körper nötig

sind. Wir werden uns dabei auf die Multiplikationen und Divisionen

beschränken (die mehr Rechenaufwand benötigen) und Additionen,

Subtraktionen und Vertauschungen von Zeilen oder Spalten außer

Acht lassen.

Die Determinante einer

![]() -Matrix besteht aus

-Matrix besteht aus

![]() vielen

Summanden, von denen jeder

ein Produkt von

vielen

Summanden, von denen jeder

ein Produkt von

![]() Zahlen ist. Man benötigt also

Zahlen ist. Man benötigt also

![]() Multiplikationen.

Um ein

Multiplikationen.

Um ein

![]() -Gleichungssystem nach der Cramer'schen

Regel zu berechnen, muß man

-Gleichungssystem nach der Cramer'schen

Regel zu berechnen, muß man

![]() Determinanten von

Determinanten von

![]() -Matrizen berechnen, benötigt als

-Matrizen berechnen, benötigt als

![]() Multiplikationen. Anschließend braucht man noch

Multiplikationen. Anschließend braucht man noch

![]() Divisionen,

was aber kaum mehr ins Gewicht fällt. Berechnet man das explizit,

dann braucht man für ein

Divisionen,

was aber kaum mehr ins Gewicht fällt. Berechnet man das explizit,

dann braucht man für ein

![]() -System

-System

![]() Multiplikationen,

ein

Multiplikationen,

ein

![]() -System benötigt

-System benötigt

![]() Multiplikationen, für

Multiplikationen, für

![]() -Systeme sind

-Systeme sind

![]() Multiplikationen nötig und bei einem

Multiplikationen nötig und bei einem

![]() -System sind es schon

-System sind es schon

![]() Multiplikationen.

Multiplikationen.

Versuchen wir auf ähnliche Weise den Gauß'schen Algorithmus zu

analysieren, dann müssen wir nur bedenken, daß man nach Satz

(4.9) jede invertierbare

![]() -Matrix (der einzige Fall in

dem die Cramer'sche Regel funktioniert) durch elementare

Zeilenoperationen in die Einheitsmatrix umgewandelt werden kann,

was genau äquivalent zur Lösung des Systems ist. Betrachten wir

also die erweiterte Matrix

-Matrix (der einzige Fall in

dem die Cramer'sche Regel funktioniert) durch elementare

Zeilenoperationen in die Einheitsmatrix umgewandelt werden kann,

was genau äquivalent zur Lösung des Systems ist. Betrachten wir

also die erweiterte Matrix

![]() des Systems. Da wir

Vertauschungen von Zeilen ignorieren, dürfen wir annehmen, daß

die erste Zeile von

des Systems. Da wir

Vertauschungen von Zeilen ignorieren, dürfen wir annehmen, daß

die erste Zeile von

![]() mit einem Element ungleich Null

beginnt. Mit

mit einem Element ungleich Null

beginnt. Mit

![]() -Divisionen erreichten wir, daß die erste Zeile

mit

-Divisionen erreichten wir, daß die erste Zeile

mit

![]() beginnt. Um in den weiteren

beginnt. Um in den weiteren

![]() vielen Zeilen das Element in der

ersten Spalte zu Null zu machen, benötigen wir pro Zeile

vielen Zeilen das Element in der

ersten Spalte zu Null zu machen, benötigen wir pro Zeile

![]() -Multiplikationen. Somit sind wir mit

-Multiplikationen. Somit sind wir mit

![]() -Divisionen und

-Divisionen und

![]() Multiplikationen so weit, daß in der ersten Spalte der

erweiterten Matrix der erste Einheitsvektor

Multiplikationen so weit, daß in der ersten Spalte der

erweiterten Matrix der erste Einheitsvektor

![]() steht. Damit das

zweite Element der zweiten Zeile gleich Eins ist, brauchen wir

steht. Damit das

zweite Element der zweiten Zeile gleich Eins ist, brauchen wir

![]() Divisionen, und mit

Divisionen, und mit

![]() Multiplikationen

erreichen wir, daß in der zweiten Spalte der zweite

Einheitsvektor

Multiplikationen

erreichen wir, daß in der zweiten Spalte der zweite

Einheitsvektor

![]() steht. Induktiv sehen wir, daß wir

steht. Induktiv sehen wir, daß wir

![]() Divisionen und

Divisionen und

![]() Multiplikationen benötigen, und ein

Multiplikationen benötigen, und ein

![]() -Gleichungssystem mit

dem Gauß'schen Algorithmus zu lösen. Für ein

-Gleichungssystem mit

dem Gauß'schen Algorithmus zu lösen. Für ein

![]() -System

sind das

-System

sind das

![]() Divisionen und

Divisionen und

![]() Multiplikationen, bei einem

Multiplikationen, bei einem

![]() -System

-System

![]() Divisionen und

Divisionen und

![]() Multiplikationen und bei einem

Multiplikationen und bei einem

![]() -System

-System

![]() Divisionen und

Divisionen und

![]() Multiplikationen. Bei

einem

Multiplikationen. Bei

einem

![]() -System erhält man die moderate Zahl von

-System erhält man die moderate Zahl von

![]() Divisionen und

Divisionen und

![]() Multiplikationen.

Multiplikationen.

Andreas Kriegl 2002-02-01